Oggi ho fatto una breve uscita, fotocamera Nikon D90 e teleobiettivo Nikon 70-300 f/4.5-5.6 VR IF-ED, sono andato sulle sponde del lago di Garda a cercare se qualche papera o qualche cigno voleva farsi fotografare.

E' la prima volta che esplicitamente mi dico "Vado a fare foto di animali". Devo dire che come tipo di fotografia, quella naturalistica e paesaggistica è la mia preferita.

Andando a fotografare animali verso la sera, chiaramente bisogna sopperire alla mancanza di luce elevando leggermente gli ISO. Queste foto sono state fatte con 800<ISO<1600.

Leggendo alcuni appunti da siti di fotografi molto capaci (juza et al.) ho trovato alcuni interessanti accorgimenti.

Diaframma:

Cercare di tenere diaframmi a tutta apertura, a meno che date le dimensioni del soggetto grandi zone siano fuori fuoco. Per animali più piccoli (es. un'anatra) usare un f/4 o f/5.6. Chiudere il diaframma solo per soggetti molto piccoli come piccoli passeri (f/8, f/11).

Tempi:

Scattare con tempi brevi < 1/250 perchè gli animali non sono soggetti in posa e continuando a muoversi si rischia di ottenere foto mosse.

Flash

Per quanto riguarda il flash, usarlo solo come riempimento per dare più luce al sensore e ridurre il rumore. Utilizzare le impostazioni EV -1 oppure EV -2. Il flash deve solo fornire un po' di luce all'ambiente e non crearne una nuova.

La cosa comunque più importante è la scelta di un corretto angolo di ripresa.

Se fotografiamo in piedi un animale che sta a terra, la ripresa dall'alto verso il basso conferisce un aspetto banale alla foto.

Non appena scendiamo allo stesso livello dell'animale, senza paura di sporcarci i vestiti o di sdraiarsi per terra, riusciremo ad ottenere immagini fantastiche.

Questo è un esempio di foto scattata da sdraiato

Come scattare una buona fotografia

Avrete notato che non tutte le fotografie sono uguali. Si può avere la migliore macchina fotografia disponibile, migliaia di euro di attrezzatura ma scattare comunque pessime foto.

Una delle prime regole che si apprende ad un corso di fotografia è quella di fotografare prima con gli occhi. Inquadrare come potrebbe essere un dettaglio, rivisto in un'altra chiave, comporre con la fotocamera guardando dal mirino e se l'immagine non ci soddisfa non scattare per forza!

Spesso navigando su Facebook vedo di quelle fotografie raccapriccianti. Facce sbiancate da flash con fondi totalmente neri, visi di persone sfocati, immagini mosse al limite estremo o super rumorose.

Per evitare ciò, anche con una macchina compatta bisogna seguire certe regole.

1) Non sempre il miglior punto da cui scattare è quella da cui si guarda: cambiare angolazione, sdraiarsi per terra, avvicinarsi ed inquadrare particolari, rende la foto migliore

2) La regola dei terzi. Siamo stufi di vedere soggetti sorridenti in posa al centro dell'immagine. Se una foto deve raccontare una storia muovendo l'occhio da destra a sinistra si deve intuire qualcosa. No invece, sinistra sfondo, centro bel faccione con sorriso forzato, destra sfondo (possibilmente sottoesposto).

La regola dei terzi, consiste nel dividere virtualmente l'immagine in 9 quadranti e mettere il soggetto in uno dei quadranti esterni. Questa immagine rende perfettamente come comportarsi.

4) Chiedersi cosa si vuole veramente dalla fotografia che si sta per fare. Una volta che il rullino costava e si dovevano sviluppare le fotografie, questo accorgimento era molto sensato, ma lo è ancora oggi.

5) Dopo aver valutato tutto questo, cercare di comporre l'immagine nella maniera migliore possibile.

Una delle prime regole che si apprende ad un corso di fotografia è quella di fotografare prima con gli occhi. Inquadrare come potrebbe essere un dettaglio, rivisto in un'altra chiave, comporre con la fotocamera guardando dal mirino e se l'immagine non ci soddisfa non scattare per forza!

Spesso navigando su Facebook vedo di quelle fotografie raccapriccianti. Facce sbiancate da flash con fondi totalmente neri, visi di persone sfocati, immagini mosse al limite estremo o super rumorose.

Per evitare ciò, anche con una macchina compatta bisogna seguire certe regole.

1) Non sempre il miglior punto da cui scattare è quella da cui si guarda: cambiare angolazione, sdraiarsi per terra, avvicinarsi ed inquadrare particolari, rende la foto migliore

2) La regola dei terzi. Siamo stufi di vedere soggetti sorridenti in posa al centro dell'immagine. Se una foto deve raccontare una storia muovendo l'occhio da destra a sinistra si deve intuire qualcosa. No invece, sinistra sfondo, centro bel faccione con sorriso forzato, destra sfondo (possibilmente sottoesposto).

La regola dei terzi, consiste nel dividere virtualmente l'immagine in 9 quadranti e mettere il soggetto in uno dei quadranti esterni. Questa immagine rende perfettamente come comportarsi.

4) Chiedersi cosa si vuole veramente dalla fotografia che si sta per fare. Una volta che il rullino costava e si dovevano sviluppare le fotografie, questo accorgimento era molto sensato, ma lo è ancora oggi.

5) Dopo aver valutato tutto questo, cercare di comporre l'immagine nella maniera migliore possibile.

- Eliminare ogni elemento di disturbo non riguardante ciò che ci ha fatto prendere in mano la fotocamera

- Seguire la regola dei terzi. Se si tratta di un paesaggio, mettere la linea dell'orizzonte sulla prima o seconda retta orizzontale, mai a metà altezza.

- Comporre significa concentrarsi su forme e colori, ricordalo. Evidenzia linee prospettiche, se fai ritratto metti a fuoco sugli occhi e tieni il diaframma aperto e la nitidezza (su digitali) al minimo.

- Raccontare una storia, la foto non è solo un documento, è un ricordo, un libro da leggere

Come fotografare sulla neve

L'ambiente nevoso alpino è uno dei più bei paesaggi che si possano ammirare.

Montagne ricoperte da bianchi fiocchi, cieli azzurri, vento in quota che sposta la neve e la luce vi si riflette attraverso.

Tutto questo è bellissimo da vedere, non troppo da fotografare.

gli esposimetri infatti restano ingannati, sia dall'eccessiva luminosità che dallo sbagliato bilanciamento del bianco.

La neve, con il riverbero, trae in inganno un normale esposimetro a luce riflessa, per cui il consiglio è

1) Per il bilanciamento del bianco, impostarlo prima della sessione fotografica, magari aiutandosi con un cartoncino grigio neutro

2) Per l'esposizione, tenere esposto a destra di 0.3 - 0.7 stop, senza comunque mai eccedere per non avere una massa totalmente bianca al posto della neve.

Questa fotografia, (Passo del Brennero) è stata scattata con un bias di esposizione di 0.7

Il sito luminous-landscape afferma che la neve illuminata dal sole è da uno stop e mezzo a due stop più luce del grigio neutro 18% - cioè quello che si aspetterebbe l'esposimetro di vedere.

Questo significa che quando si misura una scena con molta neve, la macchina espone il suo bianco come un grigio. Non sono completamente d'accordo. Alle nostre latitudini, la sovraesposizione corretta è al massimo di 1.3 stop.

Una soluzione è utilizzare un esposimetro manuale, altrimenti è quella di esporre a destra di uno stop - uno stop e mezzo.

Se si hanno a disposizione più scatti sarà conveniente scattare con un bracketing d'esposizione di almeno 3 scatti ognuno a differenze di 0.3 stop, per poter valutare poi quale foto sia la meglio esposta, ricordiamo di fare questa valutazione sempre guardando all'istogramma.

Alcuni possono dimenticarsi ogni volta di esporre a destra, per questo viene in aiuto la compensazione dell'esposizione. Questa è indicata su ogni fotocamera digitale con il simbolo +/-.

Il mio personale consiglio è che in situazioni di cielo sereno e sole prossimo a mezzogiorno si debba mantenere la fotografia sovraesposta di 0.7 stop, mentre se il sole è a mezzogiorno utilizzare una sovraesposizione di 0.3 stop.

Altre situazioni di necessaria esposizione a destra sono: mare piatto in giorni molto assolati e dune di sabbia desertiche.

Montagne ricoperte da bianchi fiocchi, cieli azzurri, vento in quota che sposta la neve e la luce vi si riflette attraverso.

Tutto questo è bellissimo da vedere, non troppo da fotografare.

gli esposimetri infatti restano ingannati, sia dall'eccessiva luminosità che dallo sbagliato bilanciamento del bianco.

La neve, con il riverbero, trae in inganno un normale esposimetro a luce riflessa, per cui il consiglio è

1) Per il bilanciamento del bianco, impostarlo prima della sessione fotografica, magari aiutandosi con un cartoncino grigio neutro

2) Per l'esposizione, tenere esposto a destra di 0.3 - 0.7 stop, senza comunque mai eccedere per non avere una massa totalmente bianca al posto della neve.

Questa fotografia, (Passo del Brennero) è stata scattata con un bias di esposizione di 0.7

Il sito luminous-landscape afferma che la neve illuminata dal sole è da uno stop e mezzo a due stop più luce del grigio neutro 18% - cioè quello che si aspetterebbe l'esposimetro di vedere.

Questo significa che quando si misura una scena con molta neve, la macchina espone il suo bianco come un grigio. Non sono completamente d'accordo. Alle nostre latitudini, la sovraesposizione corretta è al massimo di 1.3 stop.

Una soluzione è utilizzare un esposimetro manuale, altrimenti è quella di esporre a destra di uno stop - uno stop e mezzo.

Se si hanno a disposizione più scatti sarà conveniente scattare con un bracketing d'esposizione di almeno 3 scatti ognuno a differenze di 0.3 stop, per poter valutare poi quale foto sia la meglio esposta, ricordiamo di fare questa valutazione sempre guardando all'istogramma.

Alcuni possono dimenticarsi ogni volta di esporre a destra, per questo viene in aiuto la compensazione dell'esposizione. Questa è indicata su ogni fotocamera digitale con il simbolo +/-.

Il mio personale consiglio è che in situazioni di cielo sereno e sole prossimo a mezzogiorno si debba mantenere la fotografia sovraesposta di 0.7 stop, mentre se il sole è a mezzogiorno utilizzare una sovraesposizione di 0.3 stop.

Altre situazioni di necessaria esposizione a destra sono: mare piatto in giorni molto assolati e dune di sabbia desertiche.

Nikon 70-300 VR o 80-200 bighiera?

Un'interessante discussione fra appassionati sulla scelta fra Nikon 80-200 bighiera e l'ultimo 70-300 f/3.5-5.6 VR IF-ED G

http://www.nikonclubitalia.com/forum/Nikkor-70-300VR-Nikkor-80-200-bi-g-t10301.html

Io possiedo, montato sulla mia macchina Nikon D90 l'ultima ottica in questione. L'ho trovato usato direttamente dalla sezione usato del sito www.nital.it

Si tratta, a mio parere, di un ottica favolosa. In mano non da la solita impressione di plastica ma trasmette un certo senso di solidità che altre ottiche non hanno.

Le modalità di riduzione della vibrazione mi hanno davvero stupefatto. Va bene, stavo scattando sulla neve e la luminosità non mancava, ma mi trovavo ad una cinquantina di metri in linea d'aria, fotocamera in mano ed ho fatto questo scatto, diciamo "sportivo"

Devo ancora tirare fuori il meglio da questo obiettivo ma so che mi darà grandi soddisfazioni.

Forse (e probabilmente) l'80-200 bighiera farà di meglio anche perchè è più luminoso, ma penso che in rapporto al prezzo che ha i due obiettivi siano sullo stesso livello.

Su photodo.com l'80-200 f/2.8 riporta un voto molto alto, 4.94/5 mentre il 70-300 f/4.5-5.6 non è ancora classificato (obiettivo da non confondere con il mediocre 70-300 f/4-5.6)

Accetto commenti.

http://www.nikonclubitalia.com/forum/Nikkor-70-300VR-Nikkor-80-200-bi-g-t10301.html

Io possiedo, montato sulla mia macchina Nikon D90 l'ultima ottica in questione. L'ho trovato usato direttamente dalla sezione usato del sito www.nital.it

Si tratta, a mio parere, di un ottica favolosa. In mano non da la solita impressione di plastica ma trasmette un certo senso di solidità che altre ottiche non hanno.

Le modalità di riduzione della vibrazione mi hanno davvero stupefatto. Va bene, stavo scattando sulla neve e la luminosità non mancava, ma mi trovavo ad una cinquantina di metri in linea d'aria, fotocamera in mano ed ho fatto questo scatto, diciamo "sportivo"

Devo ancora tirare fuori il meglio da questo obiettivo ma so che mi darà grandi soddisfazioni.

Forse (e probabilmente) l'80-200 bighiera farà di meglio anche perchè è più luminoso, ma penso che in rapporto al prezzo che ha i due obiettivi siano sullo stesso livello.

Su photodo.com l'80-200 f/2.8 riporta un voto molto alto, 4.94/5 mentre il 70-300 f/4.5-5.6 non è ancora classificato (obiettivo da non confondere con il mediocre 70-300 f/4-5.6)

Accetto commenti.

Obiettivi Nikon novità 2010

Oggi Nikon presenta due nuovi obiettivi

AF-S NIKKOR 16-35mm F/4G ED VR. Questa nuova ottica, in funzione della sua versatilità, si propone come obiettivo “multi uso” destinato alla fotografia generale di elevata qualità (perfetto in coppia con la D700, per esempio).

Nikon dichiara, in merito a questa presentazione che “l'AF-S NIKKOR 16-35mm F/4G ED VR, coprendo tutta la gamma di possibilità di scatto grandangolare, risponde perfettamente all'esigenza del mercato di avere un'alternativa più conveniente all'obiettivo ultra grandangolare professionale AF-S Zoom Nikkor 17-35mm f/2.8D IF-ED o al più recente AF-S NIKKOR 14-24mm f/2.8G ED.

Immagini a mano libera più nitide con tempi di posa lunghi

L'AF-S NIKKOR 16-35mm F/4G ED VR è il primo obiettivo ultra grandangolare con zoom e stabilizzazione ottica VR che consente di scattare con tempi di posa fino a quattro stop più lunghi. La funzione di riduzione delle vibrazioni, associata all'apertura massima f/4 quando si scatta in condizioni di scarsa illuminazione, garantisce immagini perfettamente nitide, anche se realizzate a mano libera.

Sarei curioso di provarlo, una buona ottica grandangolare mi manca e questo non dovrebbe costare un occhio della testa

AF-S NIKKOR 16-35mm F/4G ED VR. Questa nuova ottica, in funzione della sua versatilità, si propone come obiettivo “multi uso” destinato alla fotografia generale di elevata qualità (perfetto in coppia con la D700, per esempio).

Nikon dichiara, in merito a questa presentazione che “l'AF-S NIKKOR 16-35mm F/4G ED VR, coprendo tutta la gamma di possibilità di scatto grandangolare, risponde perfettamente all'esigenza del mercato di avere un'alternativa più conveniente all'obiettivo ultra grandangolare professionale AF-S Zoom Nikkor 17-35mm f/2.8D IF-ED o al più recente AF-S NIKKOR 14-24mm f/2.8G ED.

Immagini a mano libera più nitide con tempi di posa lunghi

L'AF-S NIKKOR 16-35mm F/4G ED VR è il primo obiettivo ultra grandangolare con zoom e stabilizzazione ottica VR che consente di scattare con tempi di posa fino a quattro stop più lunghi. La funzione di riduzione delle vibrazioni, associata all'apertura massima f/4 quando si scatta in condizioni di scarsa illuminazione, garantisce immagini perfettamente nitide, anche se realizzate a mano libera.

Sarei curioso di provarlo, una buona ottica grandangolare mi manca e questo non dovrebbe costare un occhio della testa

Come costruire un diffusore flash

Certe volte quando si scattano foto con il flash si vorrebbe che le ombre siano meno marcate, i contrasti meno intensi e che le imperfezioni siano più sfocate.

Un modo per fare questo è fare diffondere la luce del flash da diversi angoli.

Se la luce incidente sul soggetto arriva con diverse angolature, tutte le ombre verranno annullate e non sarà data nessuna direzione preferenziale

Il risultato, montato sulla mia Nikon D90 con il flash Metz 48 AF-1 è quello mostrato nella prima figura.

Su alcuni siti è indicato come costruire il proprio diffusore flash, basandosi unicamente su 4 cose

1) Un foglio di cartoncino o di PVC piuttosto spesso ma al contempo facile da piegare

2) Nastro di velcro (nel caso in cui si voglia poterlo trasportare facilmente, altrimenti bastano due cambrette.

3) Una forbice o un taglierino

4) Pazienza (neanche tanta perchè in 15 minuti si fa tutto)

Istruzioni

Scaricate e stampate questo file

http://www.diyphotography.net/files/fms/fms.mdi

Contiene 6 pagine da stampare su formato A4, che una volta riunite risulteranno in questa forma

Ciò che basta fare è poi piegare e mettere sul proprio flash (con un po' di scotch ad esempio) la forma ripiegata tutta all'interno

Davanti si può mettere un foglio di carta velina o di seta sottile, chiaramente il colore di questo influirà sul colore effettivo della fotografia finale.

Per maggiori informazioni

http://www.diyphotography.net/homestudio/cheap-diy-flash-mounted-softbox

Buon softbox a tutti!

Un modo per fare questo è fare diffondere la luce del flash da diversi angoli.

Se la luce incidente sul soggetto arriva con diverse angolature, tutte le ombre verranno annullate e non sarà data nessuna direzione preferenziale

Il risultato, montato sulla mia Nikon D90 con il flash Metz 48 AF-1 è quello mostrato nella prima figura.

Su alcuni siti è indicato come costruire il proprio diffusore flash, basandosi unicamente su 4 cose

1) Un foglio di cartoncino o di PVC piuttosto spesso ma al contempo facile da piegare

2) Nastro di velcro (nel caso in cui si voglia poterlo trasportare facilmente, altrimenti bastano due cambrette.

3) Una forbice o un taglierino

4) Pazienza (neanche tanta perchè in 15 minuti si fa tutto)

Istruzioni

Scaricate e stampate questo file

http://www.diyphotography.net/files/fms/fms.mdi

Contiene 6 pagine da stampare su formato A4, che una volta riunite risulteranno in questa forma

Piegate i bordi esterni tutti all'interno e sulle ali interne mettete il velcro, come indicato nella seguente immagine (il velcro è nero)

Davanti si può mettere un foglio di carta velina o di seta sottile, chiaramente il colore di questo influirà sul colore effettivo della fotografia finale.

Per maggiori informazioni

http://www.diyphotography.net/homestudio/cheap-diy-flash-mounted-softbox

Buon softbox a tutti!

Acquisizione dell'immagine nel CCD

Per acquisire i colori si usano delle maschere di filtri colorati (sottrattive o addittive).

La percezione del colore nell'uomo avviene attraverso stadi diversi:

Oltre all'utilizzo di maschere si usano delle microlenti poiché non tutta l'area del sensore è attiva.

CCD a Frame Transfer (FT)

La matrice di esposizione e quella di accumulo sono interlacciate, quindi con un solo colpo di clock si riesce a trasferire tutte le cariche nella zona di registro a scorrimento. Che portano le cariche a un registro orizzontale. L'operazione è motlo veloce e quindi non necessitano di shutter. L'area attiva (fill factor) è minore rispetto alle frame transfer e quindi si utilizzano delle microlenti .

CCD lineari:

Quelli utilizzati nei dispositivi a scorrimento come fax, fotocopiatrici, scanner.

La percezione del colore nell'uomo avviene attraverso stadi diversi:

- livello fisico: interazione dei fotoni con la retina;

- livello fisiologico: trasduzione dei segnali elettrici

- livello psicologico: (dominante) regola la sensazione dei colori.

Oltre all'utilizzo di maschere si usano delle microlenti poiché non tutta l'area del sensore è attiva.

CCD a Frame Transfer (FT)

Usati principalmente per scopi scientifici, hanno un accumulo di carica lento. Non accumulano e leggono contemporaneamente. Sono due matrici affiancate: una di carica e l'altra (protetta da uno strato metallico) di lettura. Dopo la carica ogni riga della matrice viene trasferita alla matrice di lettura il cui ultimo elemento è a scorrimento e vi è associato l'elemento di lettura. Mentre la matrice di lettura viene letta, un'altra immagine può essere accumulata.

Hanno un'alta densità di pixel e possono avere un area molto ampia, nel trasferimento possono continuare a esserci generazione di carica quindi necessitano di otturatori meccanici (fotocamere full-frame)

CCD a interline transfer (IT)La matrice di esposizione e quella di accumulo sono interlacciate, quindi con un solo colpo di clock si riesce a trasferire tutte le cariche nella zona di registro a scorrimento. Che portano le cariche a un registro orizzontale. L'operazione è motlo veloce e quindi non necessitano di shutter. L'area attiva (fill factor) è minore rispetto alle frame transfer e quindi si utilizzano delle microlenti .

CCD lineari:

Quelli utilizzati nei dispositivi a scorrimento come fax, fotocopiatrici, scanner.

Come funziona un CCD?

Una prima parte sul funzionamento dal punto di vista dell'elettronica di un sensore CCD, come quello che viene montato all'interno delle nostre fotocamere, cellulari e videocamere.

Nell'eterogiunzione si mantengono le relazioni tra le bande di conduzione (tra semiconduttore e isolante) e tra banda di conduzione e il livello di Fermi (tra metallo e isolante) .

Nell'eterogiunzione si mantengono le relazioni tra le bande di conduzione (tra semiconduttore e isolante) e tra banda di conduzione e il livello di Fermi (tra metallo e isolante) .

Se consideriamo il lavoro di estrazione uguale per metallo e semiconduttore (Φm = Φs) e non iniettiamo nessun potenziale VG siamo nella condizione ideale di bande piatte.

Il cuore di un rivelatore per immagini CCD è il condensatore CMOS: un'eterogiunzione di Metallo, Ossido, Semiconduttore (drogato).

Nell'eterogiunzione si mantengono le relazioni tra le bande di conduzione (tra semiconduttore e isolante) e tra banda di conduzione e il livello di Fermi (tra metallo e isolante) .

Nell'eterogiunzione si mantengono le relazioni tra le bande di conduzione (tra semiconduttore e isolante) e tra banda di conduzione e il livello di Fermi (tra metallo e isolante) .Se consideriamo il lavoro di estrazione uguale per metallo e semiconduttore (Φm = Φs) e non iniettiamo nessun potenziale VG siamo nella condizione ideale di bande piatte.

Per poter sfruttare il condensatore CMOS come un accumulatore di carica dobbiamo polarizzare positivamente l'eterogiunzione. Abbiamo diversi regimi di polarizzazione:

1) Regime di svuotamento ed inversione

Con un potenziale positivo sul gate (metallo) allontaniamo le lacune verso il bulk, e si scopre così la carica spaziale creando una zona di svuotamento come avviene per una giunzione p-n. Ai lati dell'isolante abbiamo due distribuzioni di carica: puntiforme sul metallo e la zona svuotata nel semiconduttore, equivalenti in modulo. Al crescere del potenziale di gate si estende la zona di svuotamento, e la compensazione delle cariche per mantenere l'equilibrio viene non solo dalla zona di svuotamento ma anche dagli elettroni generati termicamente che possono finire in banda di conduzione (con VG alta sono più probabili perché con la bande piegate si ottiene che il livello di Fermi si avvicini alla banda di conduzione ottenendo così una differenza in energia sempre più vicina a KT). Si arriva a una soglia di inversione quando la carica di inversione Qn è pari al drogaggio del semiconduttore; in elevata inversione invece la Qn è maggiore del drogaggio.

In questi regimi il condensatore è all'equilibrio.

In questi regimi il condensatore è all'equilibrio.

Se la commutazione della tensione

di gate da nulla a molto positiva è molto veloce si va in una

situazione di non equilibrio per cui le lacune si spostano

instantaneamente. La commutazione è più veloce del tempo di

generazione termica degli elettroni. Quindi questo stato di non

equilibrio permane fino al momento in cui inizio ad avere

generazione spontanea, che però per un semiconduttore puro può

durare anche decine di minuti.

L'equilibrio può essere raggiunto

anche tramite la generazione ottica, che per le differenze di rate

di generazione è prevalente rispetto alla termica.

Si va così a

sfruttare l'ampia zona di svuotamento come un serbatoio di cariche

generate otticamente.

All'accumularsi di cariche si riduce la

zona di svuotamento e si riduce anche il potenziale Φs che va a

cadere sul semiconduttore. L'accumulo di cariche avviene fino a al

raggiungimento della soglia di inversione (come un bicchiere che si

riempie).

Il funzionamento di un CCD

Il condensatore CMOS oltre

all'accumulazione della carica permette di trasferirla se ho più

CMOS costruiti sullo stesso bulk (difatti originariamente il CCD non

nasce come rivelatore di immagini, ma come memoria a registro di

scorrimento).

La carica accumulata si trasferisce di

condensatore in condensatore fino a uno stadio terminale dove viene

estratta e trasformata in potenziale: alla fine della catena di

condensatori si crea una buca di potenziale profonda con una

diffusione n+, in modo che tutta la zona svuotata sia nel substrato

p. Con le varie commutazioni di tensione tra i CMOS si sposta la

carica in questa buca di potenziale e tramite un MOSFET si può

misurare facilmente il potenziale associato alla carica accumulata.

Nota: se i CCD fossero realizzati come

sono stati trattati avrebbero una qualità pessima: per acquisire

immagini è importante la purezza e quindi che sia davvero

trascurabile la generazione termica, l'interfaccia tra ossido e

silicio è piena di difetti e quindi appena si crea la deep depletion

la generazione termica incombe immediatamente, quindi con un diverso

tipo di eterogiunzione si ottengono i cosiddetti dispositivi a canale

sepolto nei quali prima di arrivare all'ossido il potenziale si

abbassa e si ottiene una zona di svuotamento protetta dai difetti

dell'interfaccia: le cariche sono lontane dall'ossido

Ricostruzione del colore in fotografia digitale

Come si ottiene il colore da un sensore di immagine?

Fino ad ora abbiamo descritto solo il funzionamento di sensori monocromatici. Ogni tipo di materiale risponde a luce di frequenze diverse con una diversa efficienza quantica, ovvero convertendo solo una certa parte dei fotoni entranti in carica elettrica.

Per poter capire la cattura del colore è necessario per prima separare la luce nelle sue componenti fondamentali, RBG. Il modo più ovvio di fare ciò è utilizzare tre sensori diversi, uno per il rosso, uno per il verde ed uno per il blu. Questa tecnica è molto costosa e viene utilizzata solo in applicazioni di altissimo livello.

Un altro metodo, meno costoso, è basato su un filtro di colore montato direttamente sul sensore sopra ogni fotodiodo e corrispondente ai colori che il filtro lascia passare. Questo filtro, o pattern è detto CFA (Colour Filtering Array). L'immagine così composta da pixel a 3 a 3 di diversi colori.

Le risposte spettrali del sensore ai diversi colori però non sono tutte uguali e se non si adoperano alcuni accorgimenti può risultare che alcuni colori non possono essere riprodotti.

Microlenti (sinistra) e filtro di Bayer (destra)

La figura mostra la curva di risposta per un CCD a trasferimento interlinea (IT) con microlenti. Il CFA più utilizzato è detto di "Bayer" perchè quello che permette la migliore risposta cromatica in rapporto alla risposta dell'occhio umano. Esperimenti hanno infatti dimostrato che i pigmenti fotosensibili della fovea hanno un picco di efficienza attorno alla lunghezze d'onda corrispondenti al verde (550 nm).

Il CFA permette solamente di misurare solo un colore in ogni fotosito, gli altri due dovranno essere allora stimati.

Il processo di stima dei colori mancanti è detto "Demosaicing" oppure "colour filter interpolation" ed è svolto in seconda instanza rispetto all'acquisizione del segnale, in maniera digitale.

Il modo più semplice di interpolare il colore mancante è di assegnare al pixel il valore medio dei suoi vicini, esistono tuttavia altre tecniche più efficaci nella riproduzione dei dettagli in zone di alto contrasto.

Sistemi di interpolazione di bassa qualità portano a effetti detti Moìre. Il processo di elaborazione del segnale se effettuato in seconda istanza ,grazie al formato RAW, può portare a ridurre questi effetti tramite programmi di elaborazione, (Photoshop, Capture NX e altri)

Come le microlenti aumentano il fill-factor

Le microlenti sono microsfere di resine trasparenti poste sulla superficie del fotodiodo.

La piccola lente focheggia la luce incidente che raggiungerebbe normalmente la parte non sensibile del sensore sulla regione sensibile. In questo modo il fill-factor effettivo viene aumentato dal 30-50% fino al 70%

La sensibilità del pixel viene aumentata ma non la carica immagazzinata. Il difetto di questo sistema è che con le microlenti è che la sensibilità ISO diventa dipendente dall'apertura del diaframma infatti essa fa focheggiare sull'elemento sensibile luce entrante da angoli più elevati.

Fino ad ora abbiamo descritto solo il funzionamento di sensori monocromatici. Ogni tipo di materiale risponde a luce di frequenze diverse con una diversa efficienza quantica, ovvero convertendo solo una certa parte dei fotoni entranti in carica elettrica.

Per poter capire la cattura del colore è necessario per prima separare la luce nelle sue componenti fondamentali, RBG. Il modo più ovvio di fare ciò è utilizzare tre sensori diversi, uno per il rosso, uno per il verde ed uno per il blu. Questa tecnica è molto costosa e viene utilizzata solo in applicazioni di altissimo livello.

Un altro metodo, meno costoso, è basato su un filtro di colore montato direttamente sul sensore sopra ogni fotodiodo e corrispondente ai colori che il filtro lascia passare. Questo filtro, o pattern è detto CFA (Colour Filtering Array). L'immagine così composta da pixel a 3 a 3 di diversi colori.

Le risposte spettrali del sensore ai diversi colori però non sono tutte uguali e se non si adoperano alcuni accorgimenti può risultare che alcuni colori non possono essere riprodotti.

Microlenti (sinistra) e filtro di Bayer (destra)

La figura mostra la curva di risposta per un CCD a trasferimento interlinea (IT) con microlenti. Il CFA più utilizzato è detto di "Bayer" perchè quello che permette la migliore risposta cromatica in rapporto alla risposta dell'occhio umano. Esperimenti hanno infatti dimostrato che i pigmenti fotosensibili della fovea hanno un picco di efficienza attorno alla lunghezze d'onda corrispondenti al verde (550 nm).

Il CFA permette solamente di misurare solo un colore in ogni fotosito, gli altri due dovranno essere allora stimati.

Il processo di stima dei colori mancanti è detto "Demosaicing" oppure "colour filter interpolation" ed è svolto in seconda instanza rispetto all'acquisizione del segnale, in maniera digitale.

Il modo più semplice di interpolare il colore mancante è di assegnare al pixel il valore medio dei suoi vicini, esistono tuttavia altre tecniche più efficaci nella riproduzione dei dettagli in zone di alto contrasto.

Sistemi di interpolazione di bassa qualità portano a effetti detti Moìre. Il processo di elaborazione del segnale se effettuato in seconda istanza ,grazie al formato RAW, può portare a ridurre questi effetti tramite programmi di elaborazione, (Photoshop, Capture NX e altri)

Come le microlenti aumentano il fill-factor

Le microlenti sono microsfere di resine trasparenti poste sulla superficie del fotodiodo.

La piccola lente focheggia la luce incidente che raggiungerebbe normalmente la parte non sensibile del sensore sulla regione sensibile. In questo modo il fill-factor effettivo viene aumentato dal 30-50% fino al 70%

La sensibilità del pixel viene aumentata ma non la carica immagazzinata. Il difetto di questo sistema è che con le microlenti è che la sensibilità ISO diventa dipendente dall'apertura del diaframma infatti essa fa focheggiare sull'elemento sensibile luce entrante da angoli più elevati.

Tecnica del sensore CCD e CMOS

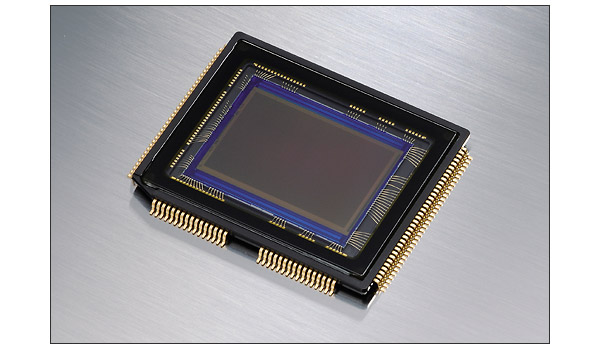

Il sensore digitale è considerato il cuore di un dispositivo d'immagine digitale.

I chip in silicio hanno dimensioni di un francobollo ma contengono milioni di elementi fotosensibili chiamati "fotositi".

Scopo di questi elementi è la conversione della luce in segnali elettrici che vengono processati successivamente da un convertitore analogico-digitale.

Sensore CCD e sensore CMOS

Partire dalla definizione di fotone è faccenda lunga, a noi basta immaginare che esso rappresenta un "pacchetto" di energia proprio di una radiazione luminosa.

Esistono due tipi principali di sensori elettronici d'immagine.

Il primo è detto CCD (charge-coupled device) il secondo CMOS (Complementary metal-oxide semiconductor).

La tecnologia dei sensori CCD è risalente agli anni 60 grazie ai lavori dei due scienziati Smith e Boyle presso i laboratori Bell. La prima implementazione del sensore CCD è stata in una videocamera. Ad ora i sensori CCD sono utilizzati in diversi ambiti della ricerca scientifica.

La differenza fondamentale fra CCD e CMOS è che il CMOS converte la carica elettrica in tensione in ogni fotoelemento mentre nel CCD la conversione è svolta in un comune amplificatore.

I maggiori vantaggi dei sensori CMOS rispetto ai CCD sono il basso consumo e basso presso di costruzione, tuttavia nel mercato odierno professionale e non i sensori CCD mostrano migliori caratteristiche per quanto riguarda sensibilità alla luce, range dinamico e rapporto segnale rumore.

Funzionamento di un sensore d'immagine

Menzione a parte merita il sensore Foveon, basato sulla tecnologia CMOS che utilizza un design a 3 livelli per catturare le 3 componenti RBG della luce.

Menzione a parte merita il sensore Foveon, basato sulla tecnologia CMOS che utilizza un design a 3 livelli per catturare le 3 componenti RBG della luce.

Conversione dei fotoni in carica elettrica

I sensori di immagine possono lavorare su uno spettro di radiazione elettromagnetica più esteso del solo visibile, sebbene quelli presenti nelle fotocamera digitali siano parametrizzati per lavorare in questo range che corrisponde a lunghezze d'onda fra 380 e 700 nm.

Il funzionamento di un elemento sensibile è dovuto alle particolarità di semiconduttore del silicio drogato.

Questo materiale presenta proprietà di conduttività a metà fra i metalli e gli isolanti. Il processo di drogaggio del silicio, che consiste nell'aggiungere atomi di elementi come rubidio, o gallio, modifica le proprietà di conduzione.

L'efficienza di un sensore si può quindi misurare come il rapporto fra fotoni entranti e fotoelettroni uscenti.

Efficienza quantica per le tre componenti

Il processo di fotoconversione rende carico il microcapacitore e questa carica viene misurata da una apposita griglia di transistor.

Architettura dell'array

Finora abbiamo introdotto il comportamento di un singolo fotodiodo, tuttavia un sensore d'immagine è composto da una griglia di elementi.

Le due architetture principali degli array di sensori sono denominate "Frame Transfer" e "Interline Transfer", il primo il più semplice ed economico da produrre.

L'array è formato da un secondo array di fotositi, o pixel, disposti in modo che la carica possa essere trasferita in parallelo verticalmente.

In questo tipo d'architettura l'intero pixel è dedicato alla cattura dell'immagine. La carica immagazzinata è identica a quella dell'array di imaging a parte che è protetta da uno schermo metallico che lo protegge dalla luce.

Subito dopo l'esposizione alla luce, la carica è velocemente trasferita una linea alla volta al CCD orizzontale dopodichè spostata in maniera seriale al convertitore di tensione.

Per ridurre la luce entrante fra il periodo di acquisizione e di scansione, viene piazzato un diaframma metallico fra lente e sensore. Questo tipo di schema di funzionamento è detto Full-Frame. Gli array full-frame sono utilizzati nelle fotocamere di alto livello.

Il secondo tipo di architettura CCD è l'array IT, mostrato nel diagramma sopra.

In questo tipo di array, ogni pixel è associato sia ad un fotodiodo sia ad un'area di immagazzinamento di carica.

Dopo l'esposizione, la carica è trasferita dal fotodiodo nell'area di raccolta carica e successivamente viene trasferita ad un registro CCD orizzontale che la trasforma in segnale di tensione.

Uno dei vantaggi del design interlinea è che è possibile riesporre il fotodiodo alla luce subito dopo la prima esposizione, permettendo quindi la registrazione di video.

Le fotocamere digitali attuali utilizzano quasi tutte questo schema.

Il maggior svantaggio dello schema IT è che una significante porzione del sensore viene allocata all'immagazzinazione dell'immagine e quindi non è più sensibile.

Il rapporto fra queste area è detto tecnicamente "fill-factor" ed è tipicamente vicino al 30-50%.

Un fill-factor minore riduce la sensibiltità del pixel e porta ad un maggior rumore e minore risoluzione.

Il fill-factor può venire migliorato grazio all'utilizzo di microlenti apposte singolarmente sul singolo elemento fotosensibile.

Pixel otticamente neri

Questo gruppo di fotositi, localizzato alla periferia esterna del sensore, è coperto da uno schermo metallico che protegge dalla luce durante l'esposizione. Questi pixel giocano un ruolo fondamentale nel riferimento del punto di nero dell'immagine, poichè non vengono investiti dalla radiazione luminosa. Il riferimento data da questi pixel è noto come "corrente oscura" ed il suo valore viene rimosso da tutti gli altri pixel dopo l'esposizione. Questo accorgimento assicura di rimuovere il segnale di sottofondo rumoroso.

I chip in silicio hanno dimensioni di un francobollo ma contengono milioni di elementi fotosensibili chiamati "fotositi".

Scopo di questi elementi è la conversione della luce in segnali elettrici che vengono processati successivamente da un convertitore analogico-digitale.

Sensore CCD e sensore CMOS

Partire dalla definizione di fotone è faccenda lunga, a noi basta immaginare che esso rappresenta un "pacchetto" di energia proprio di una radiazione luminosa.

Esistono due tipi principali di sensori elettronici d'immagine.

Il primo è detto CCD (charge-coupled device) il secondo CMOS (Complementary metal-oxide semiconductor).

La tecnologia dei sensori CCD è risalente agli anni 60 grazie ai lavori dei due scienziati Smith e Boyle presso i laboratori Bell. La prima implementazione del sensore CCD è stata in una videocamera. Ad ora i sensori CCD sono utilizzati in diversi ambiti della ricerca scientifica.

La differenza fondamentale fra CCD e CMOS è che il CMOS converte la carica elettrica in tensione in ogni fotoelemento mentre nel CCD la conversione è svolta in un comune amplificatore.

I maggiori vantaggi dei sensori CMOS rispetto ai CCD sono il basso consumo e basso presso di costruzione, tuttavia nel mercato odierno professionale e non i sensori CCD mostrano migliori caratteristiche per quanto riguarda sensibilità alla luce, range dinamico e rapporto segnale rumore.

Funzionamento di un sensore d'immagine

Menzione a parte merita il sensore Foveon, basato sulla tecnologia CMOS che utilizza un design a 3 livelli per catturare le 3 componenti RBG della luce.

Menzione a parte merita il sensore Foveon, basato sulla tecnologia CMOS che utilizza un design a 3 livelli per catturare le 3 componenti RBG della luce.Conversione dei fotoni in carica elettrica

I sensori di immagine possono lavorare su uno spettro di radiazione elettromagnetica più esteso del solo visibile, sebbene quelli presenti nelle fotocamera digitali siano parametrizzati per lavorare in questo range che corrisponde a lunghezze d'onda fra 380 e 700 nm.

Il funzionamento di un elemento sensibile è dovuto alle particolarità di semiconduttore del silicio drogato.

Questo materiale presenta proprietà di conduttività a metà fra i metalli e gli isolanti. Il processo di drogaggio del silicio, che consiste nell'aggiungere atomi di elementi come rubidio, o gallio, modifica le proprietà di conduzione.

L'efficienza di un sensore si può quindi misurare come il rapporto fra fotoni entranti e fotoelettroni uscenti.

Efficienza quantica per le tre componenti

Il processo di fotoconversione rende carico il microcapacitore e questa carica viene misurata da una apposita griglia di transistor.

Architettura dell'array

Finora abbiamo introdotto il comportamento di un singolo fotodiodo, tuttavia un sensore d'immagine è composto da una griglia di elementi.

Le due architetture principali degli array di sensori sono denominate "Frame Transfer" e "Interline Transfer", il primo il più semplice ed economico da produrre.

L'array è formato da un secondo array di fotositi, o pixel, disposti in modo che la carica possa essere trasferita in parallelo verticalmente.

In questo tipo d'architettura l'intero pixel è dedicato alla cattura dell'immagine. La carica immagazzinata è identica a quella dell'array di imaging a parte che è protetta da uno schermo metallico che lo protegge dalla luce.

Subito dopo l'esposizione alla luce, la carica è velocemente trasferita una linea alla volta al CCD orizzontale dopodichè spostata in maniera seriale al convertitore di tensione.

Per ridurre la luce entrante fra il periodo di acquisizione e di scansione, viene piazzato un diaframma metallico fra lente e sensore. Questo tipo di schema di funzionamento è detto Full-Frame. Gli array full-frame sono utilizzati nelle fotocamere di alto livello.

Il secondo tipo di architettura CCD è l'array IT, mostrato nel diagramma sopra.

In questo tipo di array, ogni pixel è associato sia ad un fotodiodo sia ad un'area di immagazzinamento di carica.

Dopo l'esposizione, la carica è trasferita dal fotodiodo nell'area di raccolta carica e successivamente viene trasferita ad un registro CCD orizzontale che la trasforma in segnale di tensione.

Uno dei vantaggi del design interlinea è che è possibile riesporre il fotodiodo alla luce subito dopo la prima esposizione, permettendo quindi la registrazione di video.

Le fotocamere digitali attuali utilizzano quasi tutte questo schema.

Il maggior svantaggio dello schema IT è che una significante porzione del sensore viene allocata all'immagazzinazione dell'immagine e quindi non è più sensibile.

Il rapporto fra queste area è detto tecnicamente "fill-factor" ed è tipicamente vicino al 30-50%.

Un fill-factor minore riduce la sensibiltità del pixel e porta ad un maggior rumore e minore risoluzione.

Il fill-factor può venire migliorato grazio all'utilizzo di microlenti apposte singolarmente sul singolo elemento fotosensibile.

Pixel otticamente neri

Questo gruppo di fotositi, localizzato alla periferia esterna del sensore, è coperto da uno schermo metallico che protegge dalla luce durante l'esposizione. Questi pixel giocano un ruolo fondamentale nel riferimento del punto di nero dell'immagine, poichè non vengono investiti dalla radiazione luminosa. Il riferimento data da questi pixel è noto come "corrente oscura" ed il suo valore viene rimosso da tutti gli altri pixel dopo l'esposizione. Questo accorgimento assicura di rimuovere il segnale di sottofondo rumoroso.

Sensore della Nikon D90

http://www.dxomark.comFantastico.

Il sito di imaging scientifico DxO ha stilato la classifica delle qualità overall dei sensori di diverse macchine fotografiche, professionali, consumer ed addirittura di dorsi digitali.

La classifica vede al primo posto una fantomatica Phase One P65 Plus, ovvero un dorso digitale di altissima qualità. Roba per fotografi da studio con un certo budget.

Seconda classificata la ammiraglia di casa Nikon, la D3X e poi a seguire tutte le migliori reflex Nikon.

Cosa che sorprende parecchio è il fatto che la mia fantastica Nikon D90 ricopre il 15° gradino della classifica, davanti addirittura alle tanto blasonate Nikon D300, D300s.

La D90 si classifica prima fra le fotocamere DX abbordabili a prezzi umani, infatti prima di lei ci sono solo dorsi digitali e reflex in formato DX

La classifica è così composta ed è dominata da Nikon per quanto riguarda le posizioni più alte.

1) Phase One P65

2) Nikon D3x

3) Phase One P40

4) Nikon D3

5) Nikon D700

6) Canon EOS 1Ds Mark III

7) Canon EOS 5D Mark II

8) Sony Alpha 900

9) Sony Alpha 850

10) Hasselblad H3DII 50

11) Leaf Haptus 75S

12) Phase One P45

13) Hasselblad H3DII 39

14) Canon EOS 1Ds Mark II

15) Nikon D90

http://www.dxomark.com/index.php/eng/DxOMark-Sensor/%28appareil%29/P65-Plus/%28metrics%29/

La classifica include SOLAMENTE la qualità del sensore, ma comunque vedere la propria macchina da 1000 euro competere con certi aggeggi da professionisti ti rende contento dell'acquisto.

Il sito di imaging scientifico DxO ha stilato la classifica delle qualità overall dei sensori di diverse macchine fotografiche, professionali, consumer ed addirittura di dorsi digitali.

La classifica vede al primo posto una fantomatica Phase One P65 Plus, ovvero un dorso digitale di altissima qualità. Roba per fotografi da studio con un certo budget.

Seconda classificata la ammiraglia di casa Nikon, la D3X e poi a seguire tutte le migliori reflex Nikon.

Cosa che sorprende parecchio è il fatto che la mia fantastica Nikon D90 ricopre il 15° gradino della classifica, davanti addirittura alle tanto blasonate Nikon D300, D300s.

La D90 si classifica prima fra le fotocamere DX abbordabili a prezzi umani, infatti prima di lei ci sono solo dorsi digitali e reflex in formato DX

La classifica è così composta ed è dominata da Nikon per quanto riguarda le posizioni più alte.

1) Phase One P65

2) Nikon D3x

3) Phase One P40

4) Nikon D3

5) Nikon D700

6) Canon EOS 1Ds Mark III

7) Canon EOS 5D Mark II

8) Sony Alpha 900

9) Sony Alpha 850

10) Hasselblad H3DII 50

11) Leaf Haptus 75S

12) Phase One P45

13) Hasselblad H3DII 39

14) Canon EOS 1Ds Mark II

15) Nikon D90

http://www.dxomark.com/index.php/eng/DxOMark-Sensor/%28appareil%29/P65-Plus/%28metrics%29/

La classifica include SOLAMENTE la qualità del sensore, ma comunque vedere la propria macchina da 1000 euro competere con certi aggeggi da professionisti ti rende contento dell'acquisto.

Le reflex più popolari del 2009

L'ottimo sito di fotografia digitale Digital Photography School ha pubblicato l'elenco delle fotocamere più popolari del 2009. Da leggere.

http://digital-photography-school.com/top-10-popular-dslrs

http://digital-photography-school.com/top-10-popular-dslrs

Crea il tuo effetto bokeh personalizzato

Indovinate a cosa serve questo cuoricino applicato all'obiettivo...

Fra qualche riga scoprirete la meraviglia di fare finta di modificare le lamelle dell'obiettivo.

Bokeh è un termine adattato dal giapponese che significa sfocato. In fotografia con bokeh ci si riferisce al piacevole effetto che si può ottenere con diaframmi aperti e focali oltre gli 80 mm, tipici del ritratto in cui la profondità di campo ridotta mette fuori fuoco le sorgenti luminose fuori dal piano di fuoco.

La qualità del bokeh in genere è data dal numero di lamelle del diaframma, tante più sono le lamelle, tanto migliore e uniforme è la sfocatura.

E' possibile però giocare con l'ottica e simulare lamelle di forme diverse per ottenere effetti particolari e creare fonti luminose di forme e dimensioni diverse dal classico cerchio, ora vi mostro come.

1) Usare un obiettivo preferibilmente con grande apertura, ad esempio il Nikon 50mm f/1.8 D

2) Con le forbici o il taglierino ritagliare da un cartoncino nero la forma voluta ed attaccarlo all'obiettivo.

3) Un diametro di circa 15 mm centrato può andare più che bene per una lente di 50 mm mantenendo un'apertura f/3.2

4) Ricodarsi di scattare a tutta apertura! Il bokeh è tanto più evidente quanto più sono divergenti i raggi di luce entranti.

Ecco qua alcuni bellissimi esempi, anche con un semplice tutorial in inglese

Fra qualche riga scoprirete la meraviglia di fare finta di modificare le lamelle dell'obiettivo.

Bokeh è un termine adattato dal giapponese che significa sfocato. In fotografia con bokeh ci si riferisce al piacevole effetto che si può ottenere con diaframmi aperti e focali oltre gli 80 mm, tipici del ritratto in cui la profondità di campo ridotta mette fuori fuoco le sorgenti luminose fuori dal piano di fuoco.

La qualità del bokeh in genere è data dal numero di lamelle del diaframma, tante più sono le lamelle, tanto migliore e uniforme è la sfocatura.

E' possibile però giocare con l'ottica e simulare lamelle di forme diverse per ottenere effetti particolari e creare fonti luminose di forme e dimensioni diverse dal classico cerchio, ora vi mostro come.

1) Usare un obiettivo preferibilmente con grande apertura, ad esempio il Nikon 50mm f/1.8 D

2) Con le forbici o il taglierino ritagliare da un cartoncino nero la forma voluta ed attaccarlo all'obiettivo.

3) Un diametro di circa 15 mm centrato può andare più che bene per una lente di 50 mm mantenendo un'apertura f/3.2

4) Ricodarsi di scattare a tutta apertura! Il bokeh è tanto più evidente quanto più sono divergenti i raggi di luce entranti.

Ecco qua alcuni bellissimi esempi, anche con un semplice tutorial in inglese

Sirenetta

La sirenetta.

Fotografia scattata con un Nikon 50 mm f/1.8 D su Nikon D90 a mano libera. 1/80 s - f/8 ISO 3200

Qualche passaggio di riduzione del rumore effettuato con Capture NX 2

50 azioni gratis per Adobe Photoshop

Un bel pacchetto delle cosiddette Photoshop Actions per modificare le proprie fotografie.

Comprendono

1) Effetto anticato, ma anticato tanto, con colori seppiati, fondo sfocato e falsi graffi

2) Effetto pellicola polaroid anni 90, il tipico effetto fluorescente delle foto delle vacanze al mare

Potete scaricare i file azioni da uno dei seguenti link qua:

http://rapidshare.com/files/348344679/ActionsPS.rar.html

http://www.zshare.net/download/723555479b55dc4b/

Qua ho alcuni esempi di funzionamento di questi bellissimi script completamente automatici

Tutti i crediti sono relativi ai loro autori.

Comprendono

1) Effetto anticato, ma anticato tanto, con colori seppiati, fondo sfocato e falsi graffi

2) Effetto pellicola polaroid anni 90, il tipico effetto fluorescente delle foto delle vacanze al mare

Potete scaricare i file azioni da uno dei seguenti link qua:

http://rapidshare.com/files/348344679/ActionsPS.rar.html

http://www.zshare.net/download/723555479b55dc4b/

Qua ho alcuni esempi di funzionamento di questi bellissimi script completamente automatici

Tutti i crediti sono relativi ai loro autori.

CHDK ovvero come trasformare una compatta in uno strumento di imaging avanzato

Tramite canali traversi a canon ufficiale, è possibile aggiornare il firmware delle proprie fotocamere compatte Canon Powershot.

http://chdk.wikia.com/wiki/CHDK

Questo insieme di strumenti di sviluppo permettono di salvare direttamente in formato RAW anche se poi chissà quale programma sarà capace di aprire un file RAW di una macchina che originalmente non lo supporta.

Si aggiunge inoltre un comodo indice di carica percentuale della batteria che indica precisamente l'avanzare del consumo d'energia di carica.

Come su alcune reflex si aggiunge poi l'istogramma dell'immagine in tempo reale direttamente nel display ed è possibile effettuare zoomate all'interno delle riprese video, caratteristica che mancava.

Altre caratteristiche sono il bracketing automatico con temporizzatore, la possibilità di creare script per il time-lapse "on-camera", motion detection e molto altro anco

http://chdk.wikia.com/wiki/CHDK

Questo insieme di strumenti di sviluppo permettono di salvare direttamente in formato RAW anche se poi chissà quale programma sarà capace di aprire un file RAW di una macchina che originalmente non lo supporta.

Si aggiunge inoltre un comodo indice di carica percentuale della batteria che indica precisamente l'avanzare del consumo d'energia di carica.

Come su alcune reflex si aggiunge poi l'istogramma dell'immagine in tempo reale direttamente nel display ed è possibile effettuare zoomate all'interno delle riprese video, caratteristica che mancava.

Altre caratteristiche sono il bracketing automatico con temporizzatore, la possibilità di creare script per il time-lapse "on-camera", motion detection e molto altro anco

Come creare uno slideshow del proprio account Flickr

Il sito è

permette, dato il proprio account di creare un bello slideshow in flash come il seguente

Created with Admarket's flickrSLiDR.

permette, dato il proprio account di creare un bello slideshow in flash come il seguente

Created with Admarket's flickrSLiDR.

Nikon Capture NX 2.2.4 Mac OSX

Link funzionanti per la versione di prova di Nikon Capture NX 2.2.4 per computer Mac OsX Tiger-Leopard-Snow Leopard

http://www.rapidsharemix.com/?q=nikon+capture+nx+2.2.4

I link sono funzionanti

http://www.rapidsharemix.com/?q=nikon+capture+nx+2.2.4

I link sono funzionanti

L'esposizione a destra

Questa guida è tratta dal manuale di Alessandro Brizzi del NikonClub

L’esposizione a destra rappresenta un importante metodo di lavoro nella fotografia digitale, che permette al fotografo di ottenere foto meno rumorose e qualitativamente migliori.

http://www.angelofragliasso.it/sottoesposizione.html

Le motivazioni sono legate al funzionamento dell’elettronica a bordo della fotocamera, che riserva un trattamento non uniforme alla luce in ingresso. In particolare si vedrà come le macchine fotografiche digitali trattino meglio le alte luci e penalizzino le ombre, rendendole più rumorose.

La spiegazione necessita di alcuni concetti di elettronica digitale, che verranno esposti in modo didattico e senza alcuna pretesa scientifica, ma solo con lo scopo di far capire al fotografo come influiscano sulla resa finale dello scatto.

L’esposizione a destra risulterà come logica conseguenza proprio del comportamento dell’elettronica di bordo.Cosa significa esporre a destra? Il termine esposizione a destra si riferisce alla tecnica utilizzata in fotografia digitale, che spinge il fotografo ad adottare coppie tempo-diaframma, per una fissata sensibilità, che portino a sovresporre leggermente la foto.

In particolare quando si dice “a destra” ci si riferisce alla parte dell’istogramma che riguarda le alte luci, che per l’appunto sono nella parte destra del grafico. Lavorando con questa tecnica quindi l’istogramma presenterà sempre delle componenti non nulle nelle alte luci.

Per esporre a destra occorre lavorare con l’esposimetro regolato sulla misurazione spot, puntato sulla sorgente più luminosa presente nell’inquadratura. Bisogna quindi andare a cercare, muovendo la fotocamera, i punti più chiari, valutando di volta in volta quale sia quello più luminoso (il più luminoso sarà quello che avrà un tempo di scatto più rapido a diaframma impostato o un diaframma più chiuso per un tempo prefissato). Una volta individuato il punto più luminoso, occorre bloccare l’esposizione con l’apposito tasto fornito sulla fotocamera e ricomporre l’inquadratura.

Prima di premere il pulsante di scatto occorre aver regolato opportunamente la compensazione dell’esposizione.

Il motivo per cui è necessario compensare l’esposizione è legato al funzionamento dell’esposimetro.

Se infatti seguiamo i passi elencati precedentemente, andando a misurare l’esposizione spot sulla sorgente più luminosa, questa sarà sicuramente sottoesposta dall’esposimetro, che è tarato su un grigio più scuro.

L’esposimetro suggerisce una coppia tempo diaframma per rendere la sorgente su cui lo stiamo puntando, pari al grigio su cui esso è tarato. Se scattiamo quindi senza compensare l’esposizione, la foto risulterà inevitabilmente sottoesposta nel complesso, perché il punto più luminoso lo stiamo rendendo come il grigio su cui è tarato l’esposimetro, che non è certo assimilabile ad una sorgente luminosa (ad es il grigio 18% è piuttosto scuro).

Di quanto compensare allora? In teoria occorre compensare l’esposizione di tanti stop (o frazioni di) quanti ce ne sono di differenza tra il grigio su cui è tarato l’esposimetro e la sorgente su cui si sta misurando.

Certo non è pratico adottare questo principio teorico, quindi nella pratica occorre procedere per errori, fino ad arrivare a prendere confidenza con la macchina fotografica e i diversi contesti, per ottenere il risultato sperato.

Bisogna sottolineare che la compensazione, che è comunque sempre positiva visto che bisogna sovraesporre, cambia da contesto a contesto e da modello a modello di fotocamera. Ad esempio per un cielo sereno o un cielo nuvoloso le compensazioni possono essere diverse; stessa cosa per diversi modelli di fotocamera con sensori e latitudini di posa del sensore diverse. Personalmente ho potuto constatare che la compensazione si aggira su valori che spaziano da +1.0EV a +1.7EVCerto non è pratico adottare questo principio teorico, quindi nella pratica occorre procedere per errori, fino ad arrivare a prendere confidenza con la macchina fotografica e i diversi contesti, per ottenere il risultato sperato. Bisogna sottolineare che la compensazione, che è comunque sempre positiva visto che bisogna sovraesporre, cambia da contesto a contesto e da modello a modello di fotocamera.

Ad esempio per un cielo sereno o un cielo nuvoloso le compensazioni possono essere diverse; stessa cosa per diversi modelli di fotocamera con sensori e latitudini di posa del sensore diverse. Personalmente ho potuto constatare che la compensazione si aggira su valori che spaziano da +1.0EV a +1.7EV. A questa compensazione, che non fa altro che rispondere al comportamento dell’esposimetro, occorre aggiungere una leggera sovraesposizione (di circa +0.3EV), che permette di sfruttare al massimo la risposta del sensore per le alte luci.

Mediamente quindi, ma da intendersi solo come esperienza personale e non come dato scientifico, il range di valori che attribuisco alla compensazione spaziano da +1.3EV a +2.0EV, a seconda del contesto (ad esempio compensazioni a +2.0EV sono state applicate in contesti di cielo nuvoloso). Come si può capire in fase di scatto se la compensazione è stata sufficiente? Gli strumenti che si hanno a disposizione sulla fotocamera, permettono di capire se occorre ripetere lo scatto modificando il valore di compensazione?

A seguito dello scatto occorre guardare sul display due informazioni: l’istogramma RGB (è sufficiente questo, ma si può fare anche tramite gli istogrammi per singolo canale) e le informazioni sulle alte luci, che nelle fotocamera Nikon sono evidenziate come lampeggianti. Entrambi questi strumenti infatti ci permettono di capire se abbiamo sufficientemente esposto a destra. Se infatti l’istogramma non arriva fino al limite destro, sicuramente la compensazione non è stata sufficiente e nello stesso caso non si avranno indicazioni di alte luci. Al contrario, se l’istogramma è tutto decisamente a destra e se le informazioni sulle alte luci ci mostrano un display molto lampeggiante, la compensazione è stata eccessiva, sovresponendo troppo. Anche qui non è possibile fornire dei dati precisi su quale sia il limite universale per capire se la compensazione è stata adeguata o no, bisogna imparare a conoscere le risposte delle fotocamera e a leggere le informazioni sul display. Per meglio comprendere la problematica riporto due esperienze personali su due modelli diversi: D70s e D700. Sulla prima fotocamera una foto era accettabile anche se l’istogramma era piuttosto spostato a destra, con la D700 assolutamente no: le luci bruciate sono quasi irrecuperabili. Il fotografo quindi deve prendere confidenza con il proprio istogramma e le informazioni sulle luci bruciate, per capire se lo scatto sarà poi recuperabile. In questo caso occorre aprire una parentesi importante sul perché le luci che da fotocamera risultano essere bruciate, siano recuperabili. Fondamentale infatti è il formato del file e questa affermazione è valida solo per i file RAW. Per un file JPEG l’istogramma è veritiero con certezza, dal momento che la foto viene compressa su camera e da questa viene calcolato l’istogramma mostrato dalla macchina stessa.

Per il RAW invece l’istogramma potrebbe non essere veritiero. Bisogna infatti specificare che per il formato RAW non esiste istogramma, ma l’istogramma che viene visualizzato a seguito dello scatto è ottenuto da una conversione JPEG fatta su camera dello scatto. Ovviamente questa conversione introduce delle perdite, essendo lossy la compressione JPEG, che possono far passare per bruciate, ad esempio, alcune luci che bruciate non sono. La conversione su camera quindi non è affatto quella che verrà fatta in camera chiara e inoltre molti programmi difotoritocco permettono di recuperare le alte luci bruciate (ad esempio Photoshop CS3 incorpora il parametro “Recupero” in Camera RAW che permette di salvare alcune luci). Ovviamente come si diceva prima, tutto dipende dal modello, perché, tornando ai due modelli citati, con D70s l’istogramma non era veritiero e bisognava veder bruciare un bel po’ di luci, su D700 quello che viene segnalato come bruciato è effettivamente tale. Tornando all’esposizione a destra allora si può riepilogare nei seguenti passi questa tecnica:

1. Impostare su SPOT l’esposimetro

2. Impostare una compensazione d’esposizione opportuna al contesto e alla fotocamera

3. Cercare la sorgente più luminosa presente nell’inquadratura, misurandovi l’esposizione

4. Bloccare l’esposizione

5. Ricomporre l’inquadratura e scattare

6. Valutare da istogramma e luci bruciate se la compensazione dell’esposizione è stata eccessiva o scarsa.

Elementi elettronici di una macchina fotografica digitale

L’acquisizione e l’elaborazione della luce in una fotocamera digitale vede coinvolti diversi attori, o meglio componenti, ognuno implicato in una particolare funzione. Uno schema può essere riepilogato come di seguito: I diversi componenti effettuano tutte le operazioni necessarie per completare la digitalizzazione della luce, che è un segnale analogico. Brevemente, un segnale analogico è una qualsiasi grandezza, per noi luce, che varia con continuità, senza “salti” e che può assumere un infinito range di valori. Questo segnale deve essere digitalizzato e diventare per l’appunto un segnale digitale. Per effettuare questa operazione bisogna prima realizzare il teorema del campionamento, che riduce il set di valori che può assumere il segnale in ingresso ad un infinito numerabile di valori, ovvero si creano i campioni del segnale. Questi verranno mandati in pasto al convertitore analogico-digitale, che tirerà fuori il segnale digitale.

Il teorema del campionamento viene effettuato dal sensore, che acquisisce i fotoni presenti nella luce in ingresso e ne crea, con i suoi fotositi, i campioni.

I campioni sono un infinito numerabile di elementi, ovvero elementi che possono assumere qualsiasi valore, ma non variano con continuità e si possono contare. Dal sensore, CCD o CMOS che sia, esce una corrente di intensità direttamente proporzionale all’intensità luminosa che ha colpito ogni fotosito. Questa corrente è di intensità comunque ridotta e deve necessariamente essere amplificata per poterla digitalizzare con il convertitore analogico- digitale (ADC – Analog to Digital Converter).

L’amplificazione è tanto più forte quanto più è l’impostazione ISO che si è scelta su camera. Occorre fare una doverosa osservazione sull’amplificazione, per spiegare come mai, all’aumentare della sensibilità, aumenta il rumore sulla foto finale. L’amplificatore non fa altro che prendere un segnale in ingresso e ne aumenta il valore in uscita di un opportuno fattore. Nel caso della reflex l’amplificatore riceve la corrente che esce dal sensore e la amplifica. Cosa comporta questo?

Questo implica che se la corrente che esce dal sensore, contenente i campioni della luce arrivata su di esso scattando la foto, contiene del rumore, anche quest’ultimo verrà amplificato. Generalmente il rumore è inferiore per intensità alle informazioni fotografiche, ma amplificando sempre di più la corrente, si finisce per fargli raggiungere un’intensità tale per cui sia visibile sulla foto.

Risulta quindi evidente come lavorando a ISO200 si abbia una certa figura di rumore (ovvero del rumore visibile sulla foto), che sarà molto minore di quello che si vede a ISO1600, che implica un amplificazione maggiore della corrente uscita dal sensore (che contiene anche il rumore). Risulta altrettanto vero allora che molto dipende da quanto rumore produce il sensore. Generalmente i CMOS sono migliori perché oltre ad essere elettronica fredda, non vengono letti in modo seriale come i CCD e quindi permettono di ottenere foto più pulite. Tornando alla catena che porta a scrivere su supporto di memoria una foto, arriviamo all’ADC, che ricopre un ruolo molto importante: a valle dell’ADC infatti avremo un segnale digitale.

La digitalizzazione di un segnale è un’operazione lineare e con perdita. Per comprendere l’operato di un ADC occorre introdurre i cosiddetti bit (binary digit). I bit sono gli elementi principali di ogni grandezza digitalizzata e sono cifre in base 2. Non spaventi questa dicitura, dal momento che come esseri umani siamo molto familiari con le cifre in base 10, che non sono altro che: 0, 1, 2, 3, 4, 5, 6, 7, 8, 9. Tutti noi sappiamo scrivere i numeri, composti come due o più cifre affiancate. In particolare quando arriviamo al 9, tutti sappiamo scrivere il numero 10, che viene ottenuto aggiungendo una cifra (il 9 è una cifra sola, 10 contiene l’1 e lo 0) e in particolare si mette uno 0 al posto più a destra e un 1 al posto di sinistra. Cosa analoga quando arriviamo a 99, infatti per scrivere 100 non facciamo altro che mettere due 0 a destra e un 1 a sinistra, ecc ecc. La base due, ovvero la base usata dai bit, fa la stessa cosa, ma con solamente due cifre: 0, 1. In base 2 allora si scriverà sempre il numero 10, ma non sarà da leggersi come “dieci”, piuttosto come “uno, zero” e che corrisponde al decimale 2. Il numero 10 (sempre “uno, zero”) in base 2 è un numero a 2 bit, come si può facilmente dedurre.Digitalizzare un segnale, per noi la corrente che esce dal sensore, significa scriverlo in cifre binarie, ovvero in bit e questo è compito dell’ADC. Il convertitore è caratterizzato da un numero di bit cui lavora, che nelle reflex più recenti sono arrivati a 14 (in altri modelli sono 12).

Questo significa che il convertitore prenderà la corrente in ingresso e ne tirerà fuori, per ogni campione, un numero in base 2 a 14 cifre, direttamente proporzionale al valore del campione, che a sua volta è direttamente proporzionale all’intensità della luce che è arrivata sui fotositi del sensore.

Ogni volta che si digitalizza un campione si introduce un errore, detto errore di quantizzazione. Come detto precedentemente infatti la digitalizzazione è un’operazione con perdita. Vediamo da cosa dipende l’errore, rappresentando graficamente una digitalizzazione a 3 bit di un segnale qualsiasi, come in figura:

Nella figura precedente abbiamo il segnale in ingresso, da digitalizzare, costituito da una retta e i cui valori saranno da cercarsi sull’asse delle ordinate (quello verticale) e saranno un infinito numerabile; in asse delle ascisse invece abbiamo i valori che assumerà il segnale a seguito della quantizzazione a 3 bit, che come si nota sono solamente 8 e sono tutti numeri binari a 3 cifre. Si vede come il segnale in uscita non rispecchi esattamente il segnale in ingresso, visto che avrà solamente 8 valori diversi. Il segnale digitalizzato è stato fatto a fette e dalla figura seguente si vede dove si introduce l’errore:

I valori a e b del segnale in ingresso sono entrambi resi nel segnale in uscita come 011, nonostante questi siano effettivamente due valori diversi. Questo è l’errore di quantizzazione: digitalizzando un segnale, che viene rappresentato con un set discreto di valori.

Facciamo un altro esempio, considerando i numeri. Prendiamo i numeri 1 e 2 e supponiamo di rappresentare solo con questi numeri tutti i decimali tra loro contenuti, approssimando per eccesso dal valore 1,5 e per difetto fino all’1,49.

Per noi quindi il numero 1,3 sarà scritto come 1 e il numero 1,5 sarà scritto come 2. Non stiamo facendo altro che introdurre anche noi un errore di quantizzazione, perché se per noi 1,5 è scritto come 2, stiamo rappresentando il numero con uno 0,5 di errore. Questo è il nostro errore di quantizzazione.

Cosa si può fare per l’errore di quantizzazione? Come si può ridurlo? Partendo dal fatto che è inevitabile, l’unica cosa da fare è quella di aumentare il numero di bit, in modo tale che le fette siano molte e fitte e il segnale sia reso meglio, con maggiore precisione. Cosa comporta scattare a 14 bit?

Quando si lavora a 14 bit si ottengono foto qualitativamente migliori di foto a 12 bit. Utilizzare infatti 14 bit, in base a quanto detto, ci mette in condizioni di ottenere errori di quantizzazione minori. Ma questo beneficio si applica a tutta la foto in maniera uniforme? La risposta è no. A prescindere infatti dal numero di bit che si usa, la macchina fotografica digitale riserva un trattamento migliore alle luci e peggiore alle ombre. Cerchiamo di capirne il motivo. Lavorando con una macchina a 14 bit si avranno 2^14 fette diverse, ovvero 16384 fette diverse in cui viene fatto il segnale.

Ma come possiamo rapportare gli stop a queste 16000 e più fette? I fotografi sono abituati ad usare gli stop per misurare l’esposizione e se quindi fosse possibile identificare una relazione che lega questa unità di misura al comportamento dell’ADC si potrebbe definire una regola che permetta di sfruttare al meglio il convertitore.Ragionando sulla definizione dello stop, sappiamo che due stop successivi sono separati da un fattore 2 o ½ a seconda che si consideri il precedente o il successivo.

Ma abbiamo altrettanto visto che anche i bit sono in base 2 e moltiplicando per 2 un numero binario, si aggiunge una cifra nel numero stesso (01 x 2 = 10). Allora spostiamo gli stop sul nostro ADC e vediamo cosa succede. Partiamo dallo stop più luminoso, quello che per intenderci contiene anche il bianco.

Il bianco, che è per l’appunto il valore massimo di luminosità che arriva sul sensore sarà rappresentato inevitabilmente dal valore massimo del convertitore, che essendo a 14 bit è pari a 11111111111111, e per gli altri valori di luminosità? Come viene trattata la luce che arriva sul sensore e che è sempre contenuta in questo stop? Dopotutto fino a quando la luce non diventa la metà siamo sempre nello stesso stop.

La luce contenuta nello stesso stop del bianco viene rappresentata con tutti quei valori binari compresi tra il massimo: 11111111111111, e il massimo diviso 2, ovvero 01111111111111 escluso, per un totale di 8192 valori diversi, ovvero 8192 fette diverse (contare per credere). Riepilogando, i valori dello stop più luminoso spazieranno nel seguente intervallo chiuso [11111111111111; 10000000000000], in cui i valori estremi sono compresi.

Possiamo allora ottenere un primo risultato: lo stop più luminoso, contenente il massimo dell’intensità luminosa che arriva sul sensore, viene digitalizzato con 8192 valori (fette) diversi. Passiamo allo stop immediatamente sotto. Cosa accade per questo stop?

Beh la risposta è semplice, i valori ad esso riservati andranno da 01111111111111 a 01000000000000 e quindi avremo 4096 valori (fette) diversi per questo stop. Per lo stop ancora sotto, avremo valori da 00111111111111 a 00100000000000 e quindi avremo 2048 valori (fette) diverse. Possiamo allora formulare il seguente enunciato: ad ogni stop che arriva sul sensore viene riservato un numero di bit significativi che si dimezza al decrescere dell’intensità luminosa del singolo stop. E se invece di lavorare a 14 bit lavorassimo a 12 bit, cosa cambierebbe? I conti sono molto semplici da fare e si avrebbe che per lo stop più luminoso, verrebbero riservati valori (fette) da 111111111111 a 100000000000, ovvero 2048 valori diversi. Facendo il confronto con quanto visto a 14 bit, dove avevamo 8192 valori diversi, si nota come a 12 bit si abbia una risoluzione inferiore di ben 4 volte.

Cosa simile accade per gli altri stop. Da quanto esposto possiamo dedurre i seguenti risultati:

1. Lavorare a 14 bit permette di avere una rappresentazione migliore del segnale digitalizzato, rispetto ai 12 bit;

2. Ogni stop via via più scuro viene digitalizzato con un numero sempre minore di bit e quindi viene reso con maggiore rumore le luci vengono trattate meglio dalla fotocamera digitale rispetto alle ombre;

3. In fase di scatto, se si include il bianco nella foto, si ottiene una foto meno rumorosa di una che non lo comprenda.

Bisogna fare molta attenzione a non confondere l’operato del convertitore analogico-digitale con la latitudine di posa del sensore.

Infatti il numero di bit del convertitore non influenza assolutamente questo parametro, che si lavori a 12 o 14 bit le caratteristiche del sensore non cambiano.

Il sensore registra la luce con la sua latitudine di posa e successivamente quanto registrato viene mandato al convertitore. Come influisce in questo l’esposizione a destra?

Dai 3 risultati precedentemente elencati si comprende facilmente come l’esposizione a destra trovi significato ed applicazione, dal momento che includendo il massimo della luminosità possibile (appunto il bianco) si ottiene una foto qualitativamente migliore.

L’esposizione a destra vale a prescindere dal numero di bit con cui si lavora, siano essi 12 o 14, dal momento che comunque lo stop più luminoso riceve un trattamento migliore in termini di digitalizzazione.

In cosa si manifesta la minore qualità, se non si include il bianco nella foto, ovvero sottoesponendo? Il risultato è da cercarsi nelle ombre, che appariranno maggiormente blocchettate, come se si trattasse di artefatto di compressione eccessiva JPEG.

Molto spesso viene sollevata l’obiezione sul fatto che lavorando con l’esposizione a destra, bruciando leggermente le luci, queste siano irrecuperabili e quindi sia meglio sottoesporre, salvando tutto e poi recuperare l’esposizione in camera chiara.

In parte si è già confutata questa affermazione, dimostrando come il trattamento riservato agli stop più luminosi sia migliore, ma si possono anche aggiungere diverse considerazioni:

1. schiarire, quindi recuperare la sottoesposizione, in fase di fotoritocco, comporta un aumento del rumore dell’immagine; scurire invece non comporta alcun rumore aggiuntivo;

2. i programmi di fotoritocco oggi permettono di recuperare con un certo margine le luci bruciate;

3. utilizzando lo spazio di colore ProPhotoRGB in fase di postproduzione è possibile ulteriormente recuperare le luci.

Si ricorda che tutto quanto esposto è valido per foto scattate in formato RAW. Circa il punto 3 precedente, che merita una trattazione adeguata, invito il lettore a fare il seguente tentativo:

si apra una foto in Adobe Camera RAW con spazio di colore sRGB e si noti l’istogramma. Successivamente si modifichi, sempre in Camera RAW lo spazio di colore in ProPhotoRGB e si noti come cambia l’istogramma, recuperando diverse luci.

L’esposizione a destra rappresenta un importante metodo di lavoro nella fotografia digitale, che permette al fotografo di ottenere foto meno rumorose e qualitativamente migliori.

http://www.angelofragliasso.it/sottoesposizione.html

Le motivazioni sono legate al funzionamento dell’elettronica a bordo della fotocamera, che riserva un trattamento non uniforme alla luce in ingresso. In particolare si vedrà come le macchine fotografiche digitali trattino meglio le alte luci e penalizzino le ombre, rendendole più rumorose.

La spiegazione necessita di alcuni concetti di elettronica digitale, che verranno esposti in modo didattico e senza alcuna pretesa scientifica, ma solo con lo scopo di far capire al fotografo come influiscano sulla resa finale dello scatto.

L’esposizione a destra risulterà come logica conseguenza proprio del comportamento dell’elettronica di bordo.Cosa significa esporre a destra? Il termine esposizione a destra si riferisce alla tecnica utilizzata in fotografia digitale, che spinge il fotografo ad adottare coppie tempo-diaframma, per una fissata sensibilità, che portino a sovresporre leggermente la foto.

In particolare quando si dice “a destra” ci si riferisce alla parte dell’istogramma che riguarda le alte luci, che per l’appunto sono nella parte destra del grafico. Lavorando con questa tecnica quindi l’istogramma presenterà sempre delle componenti non nulle nelle alte luci.

Per esporre a destra occorre lavorare con l’esposimetro regolato sulla misurazione spot, puntato sulla sorgente più luminosa presente nell’inquadratura. Bisogna quindi andare a cercare, muovendo la fotocamera, i punti più chiari, valutando di volta in volta quale sia quello più luminoso (il più luminoso sarà quello che avrà un tempo di scatto più rapido a diaframma impostato o un diaframma più chiuso per un tempo prefissato). Una volta individuato il punto più luminoso, occorre bloccare l’esposizione con l’apposito tasto fornito sulla fotocamera e ricomporre l’inquadratura.

Prima di premere il pulsante di scatto occorre aver regolato opportunamente la compensazione dell’esposizione.

Il motivo per cui è necessario compensare l’esposizione è legato al funzionamento dell’esposimetro.

Se infatti seguiamo i passi elencati precedentemente, andando a misurare l’esposizione spot sulla sorgente più luminosa, questa sarà sicuramente sottoesposta dall’esposimetro, che è tarato su un grigio più scuro.

L’esposimetro suggerisce una coppia tempo diaframma per rendere la sorgente su cui lo stiamo puntando, pari al grigio su cui esso è tarato. Se scattiamo quindi senza compensare l’esposizione, la foto risulterà inevitabilmente sottoesposta nel complesso, perché il punto più luminoso lo stiamo rendendo come il grigio su cui è tarato l’esposimetro, che non è certo assimilabile ad una sorgente luminosa (ad es il grigio 18% è piuttosto scuro).

Di quanto compensare allora? In teoria occorre compensare l’esposizione di tanti stop (o frazioni di) quanti ce ne sono di differenza tra il grigio su cui è tarato l’esposimetro e la sorgente su cui si sta misurando.